英伟达 IR 电话会议透露了很多信息。最大的两个推理用例是推荐系统和生成式 AI,其中推荐系统占 40% 中的 20%。今年的推理收入确认来自去年的购买。GTC 有超过 80% 的概率会发行 B100。供应仍然紧张,但 NVDA 能够直接了解最终客户并做出相应安排。关于 CY25 年的可见性,已经有很多信号。总体而言,这些信息展示了英伟达在推理和供应方面的优势和前景。

英伟达 IR call,信息量很大

-

产品可同时用于训练和推理,但 NV 的客户经理和解决方案架构师可通过客户提的问题判断用途,对每个客户 account 都有很强的可见性。

-

最大的两个推理用例1)推荐系统,占 40% 中的 20%(去年出卡 150w,这个比例刚好是 META 的 30w 张) -电商和社交媒体的推荐系统。(META 是一个很大的例子)…2)生成式 AI - 早期已经进入生产的客户包括MSFT Copilot、ChatGPT、NOW、ADBE。

-

去年这个比例要低得多。当客户为推理购买时,通常有几个季度的滞后时间直到建立推理。因此,今年的推理收入确认来自去年的购买。

-

关于推理卡的竞争…几年前,大多数推理都是在 CPU 上完成的,人们认为推理更容易。但是,对响应时间的需求、图像生成和视频生成提高了推理计算需求的标准。模型不断创新、软件不断改进,这对 NVDA 有利。甚至在芯片升级之前,Tensor LT LLM 仅通过软件就为 LLM 提供了 2 倍的速度提升。这就是与 ASIC 相比的好处,延长了 H100 的使用寿命。

-

供应紧张的关注…与其他终端市场相比,NV 能直接看到最终客户,从设计最终客户的基础设施到服务器/网络的大小,然后客户决定通过谁走交付(ODM,分销商等)。仍处于 “allocation mode”,比如优先从机架/网络的角度准备好了的客户。即便 cowos 供应终于赶上了,但仍在分配模式中。

-

对 CY25 年的可见性…通常没有这么远的可见性。客户通常不会提前 4-6 个季度预订。然而,已经有很多信号。了解垂直行业,他们自己的投资回报 ROI。(回答了之前文章的问题,ROI 决定了 GPU 投资的持续性)还将在新架构上继续 ramp,更好的性能、降低客户的 TCO,从而推动需求。在新架构开始时,供需往往不匹配。(我们之前说的,短期看都是供需噪音,长期看是持续紧张,因为迭代太快)

-

竞争格局…客户会从软件角度考虑他们的工作负载是否得到支持,或者是否存在软件优化的隐藏成本(暗示 AMD?)。替代方案在性能上也有差距。通过 MLPerf 基准,你可以看到性能轻松拉开 2 倍差距。对客户来说不值得,因为他们还要承担数据中心的固定成本(我理解是 TCO 比如能耗、维护),而节省的费用实际上并不能弥补这一点。性能=总拥有成本,才是客户真正在想的,而不是一个个芯片。

-

关键的供应限制…有 3 个限制因素,内存、Cowos 封装、网络。对于 H100,大部分已经缓解,现在接近结束分配(所以 lead time 3 个月很正常)。H200 下个季度将采用新的 HBM,可能又会看到限制(因为 3E 通过认证的现在就两家,海力士镁光)。新架构将更少地针对具体组件,ramp 时更多是小批量。(我理解是 unit 下降但 perf 上升,GPU density 继续提升,除个别如 substrate HBM 线性上升,其他部件不见得能跟上价值量增速)。

-

从客户方面来看,数据中心功率密度是重点。大多数超大云厂提前 2-3 年就确定了数据中心容量,计划得很早。大多数公司延长了旧服务器的使用寿命,并将支出重新分配到加速计算上。

-

主权需求…作为数据中心的一部分相对较小,但却是价值数十亿美元的机会。主权 AI 仅被定义为该国境内的人工智能基础设施。可能是私人和国有资金的混合,通常由当地的电信公司资助。比如日本的软银,新加坡的星电信。

-

企业需求拆分…略超过一半的是大型云服务提供商,接下来最大的是消费者互联网(电商和社交媒体)。其余是企业,包括 GPU 特定提供商(oracle,coreweave?据说 coreweave 24 年就订了近 1w 台)

-

B100 过渡期…现在与客户的对话是在决定在 H100、H200 和 B100 之间的支出分配。这是一个迭代过程,因为它取决于供应情况。这不是一个升级,因为 B100 不是为了替换 H100。H100 仍然会销售。当年过渡期的 Ampere 和 Hopper 在 6 个季度内也一起销售。对 H100 的需求将会持续。(划重点)

-

软件的好处…计算平台 75% 以上的毛利率包括大量软件(加速库、预训练模型、CUDA)在内。第四季度实现了 10 亿美元的年化收入,包括面向企业、GForce、DGX Cloud、vGPU、支持 DGX 系统的软件。

-

本地部署的企业内部 AI…鉴于基础设施的复杂性,大多数企业正在与云服务提供商接触以获取生成式 AI 服务。这是中期内增长最快的途径。从长远来看,大型企业将开始计划内部部署,处于成本考量。然而,云需求仍将增长,毕竟每美元的 GPU 支出中,云服务提供商收取 4-5 美元的 GPU 费用。

-

中国的影响…需求有一定的波动,供应在分配过程中进行了调整。中国客户对新产品的初步评估阶段(H20),这些产品不需要许可证,但仍支持整个软件堆栈。对客户来说仍然有价值,因为它们运行在英伟达软件堆栈上。

-

关于 GTC 的预期…将宣布新架构,业务各个部分都有更多新闻。

此外 from sicong:

-

GTC 80% 以上概率发 B100

-

目前有兩個版本的 B100ASP, 一個比較符合大众預期 3.8w(工业富联专家口径),一個是小众点的 3-3.3w(MS Joe Moore 提到了,如果价格激进,对 AMD 是巨大压力)

-

目前 B100 出货时间也有两个版本,一個是 3Q,一個是 4Q,两种情形下出貨量大概差 30w 张。个人偏向 4Q,因为 KYEC 的设备没那么快 ready

微软对 OpenAI 的会计处理,某投行专门请了会计师来分析

根据微软-OpenAI 研发协议,OpenAI 托管在 Azure 的推理产生的收入被确认为 Azure 收入(也就是季报中的那个 6%),但 OpenAI 使用 Azure 进行其模型训练的工作负载,并不被确认为收入(同样,也不在微软的 COGS 或资本支出中)。一位专业会计师来解释这种处理方式,并得出结论,微软可能在按照净额报告这些训练收入,而不是按 Gross 总额。美国财务会计准则委员会(FASB)的会计准则 808(特别是第 45 节)规定了 “合作安排”(通常称为合资企业)的会计处理方式。在公司 A(微软)投资于公司 B(OpenAI),然后公司 B 反过来使用这些资金从公司 A 获取服务(Azure 计算)的情况下,公司 A(微软)应将这种 “交换” 的收入净额化。

说到底微软采取了非常保守谨慎的处理方式,假设放在 A 股,别管这种 “内循环” 是否产生利润,还不得放到 P&L 里面虚增一把收入...

谷歌 Demis 认可了 LLMs + Tree Search 有可能实现 AGI

“树搜索 +LLM 是一个非常有前途的方向。我们正在研究像 AlphaGo 这样的规划机制,也许还可以串联不同的想法或推理线索,并利用搜索来探索巨大的可能性空间。我认为当前的大型模型缺少这种能力(planning)。那么,AGI 是否可能完全来自纯 RL 方法呢?理论上,我认为没有理由不能这样做,确实有一些人在 DeepMind、谷歌和 RL 社区中正在这方面工作。然而,尽管如此,我认为最快、最可能的方式是利用现有世界中的所有知识,比如网络上的知识,以及我们收集的知识,加上我们拥有像 Transformer 这样可以 scaling 的算法,能够吸收所有这些信息。因此我猜测最终的 AGI 系统将包含多模态大模型作为整体解决方案的一部分,但可能还不够,还需要额外的规划和搜索。”

The Information 报道了 Meta 的Llama 3,认为大概 7 月发布,希望是能达到 GPT-4 水平,最大版本 1400 亿参数。但据说负责 Llama2 和 3 安全的研究员 Louis Martin 本月离开了该公司,负责强化学习 Kevin Stone 也于本月离职。

阿里 NDR 路演要点

管理层明确表示,“今年将是投资的一年”,关注三个重点:1) 重振电商的增长;2) 处置非核心资产;3) 资本回报 4.5%(3% 股份减少 +1.5% 分红)。公司将优先考虑 GMV 而非 CMR(客户管理收入);费率不会是优先考虑的因素(尤其是考虑到淘宝相比天猫占比提高),并且会有一定的波动。公司承认拼多多的费率确实高于淘宝和天猫;他们估计拼多多的费率在 10% 以上,而淘宝/天猫的综合费率在中个位数。关于饿了么,虽然外卖被视为非核心资产,但管理层重申他们没有出售公司的计划,管理层称按需配送基础设施对淘宝 - 天猫业务具有战略意义,并将专注于提高效率和扩大规模。此外,菜鸟在市场条件合适的情况下不会排除上市的可能性。350 亿的回购不只是一个上限,公司希望确保买满 350 亿。

张俊林大佬:关于 Sora 是否是物理世界引擎

diffusion model 除了图片里物体间的空间关系,还可以额外学习到时间维度物体的运动规律,也就是物体的运动轨迹(苹果会从树上垂直落到地面),本质上是对物理世界 4 维时空的 3 维压缩(平面二维图像 + 时间维度),但是要注意的是:生成模型通过视频学会的是物体的运动规律和运动轨迹,但不是物理定律,它知道苹果应该朝下向着地面运动,因为它看过很多视频都是这样的,但这并不意味着它学会了牛顿的 “万有引力” 定律。没有人能只通过看到苹果下落就写出万有引力定律公式,包括牛顿也不行,牛顿能写出来也是经过大量实验以及抽象的推理思考才总结出来的。可以看出,图片/视频生成模型强在物体外在形象的表征、物体空间关系以及运动轨迹建模,但弱于抽象思考,即着于 “色相” 而弱于 “法”。

而语言模型 LLM,是从大量人类语言中学习知识,语言本身就是一种抽象的产物,所以 LLM 擅长对抽象知识的建模和生成,本质上 LLM 在 Transformer 的参数空间内构建了一个由抽象概念编织成的 “知识之网”,LLM 是靠不同知识之间的相互关系而不是它的 “色相” 来定义具体知识的。但其对空间概念理解比较薄弱,比如它能生成 “苹果在桌子上面”,但是估计不太理解 “苹果在桌子左边” 的空间布局是什么意思,这源于人类对空间关系的理解主要来自于视觉信道。另外,LLM 知道某个概念但是并不知道这个概念对应的外在形象具体是什么样子。所以可以看出,LLM 擅长抽象知识和抽象思考,弱于对于空间关系的理解,以及物体外在具体形象的理解。所谓 LLM 长于 “法” 而弱于 “相”。

但如果二者结合,图片/视频模型类似人类的右脑,擅长形象思维,负责形象世界的生成;LLM 类似人类的左脑,擅长语言及抽象思考,负责抽象知识和物理法则的生成和语言描述,包括复杂物理世界规律的建模和表述。如果二者能配合好,在两者之间建立起良好的 grounding,是有可能实现模型对物理世界的充分近似和理解。

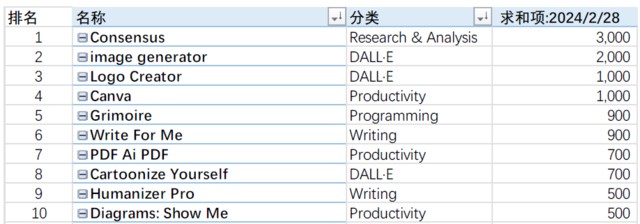

被使用最多的 GPTs 是什么?

Will 对 GPTs 做了非常详细的排名,你猜被使用最多的 GPTs 是什么,果然二级狗最勤奋...

本文作者:Jason,来源:信息平权,原文标题:《英伟达 IR Call、量化 DMA、微软 OpenAI 收入处理》,本文有删减

风险提示及免责条款

市场有风险,投资需谨慎。本文不构成个人投资建议,也未考虑到个别用户特殊的投资目标、财务状况或需要。用户应考虑本文中的任何意见、观点或结论是否符合其特定状况。据此投资,责任自负。