AI 大战升级!Meta 推出先进大型语言模型 下一个 ChatGPT 不远了?

开源的 AI“研究工具”。

当地时间 2 月 24 日,Meta 宣布将推出针对研究社区的 “Meta 人工智能大型语言模型” 系统(Large Language Model Meta AI),简称 “LLaMA”。

同 ChatGPT、New Bing 不同,LLaMA 并不是一个任何人都可以与之对话的产品,也并未接入任何 Meta 应用。更为确切地说,该产品将是一个开源的 “研究工具”。

公司 CEO 扎克伯格在社交媒体上表示,LLaMA 旨在帮助研究人员推进研究工作,LLM(大型语言模型)在文本生成、问题回答、书面材料总结,以及自动证明数学定理、预测蛋白质结构等更复杂的方面也有很大的发展前景。

1、开源的 “研究工具”

Meta 表示,LLaMA 可以在非商业许可下提供给政府、社区和学术界的研究人员和实体工作者,正在接受研究人员的申请。

此外,LLaMA 将提供底层代码供用户使用,因此用户可以自行调整模型,并将其用于与研究相关的用例。与之截然不同的是,谷歌旗下的 DeepMind 和 OpenAI 并不公开训练代码。

该公司还表示,LLaMA 作为一个基础模型被设计成多功能的,可以应用于许多不同的用例,而不是为特定任务设计的微调模型。

2、比 GPT3.5 性能更强

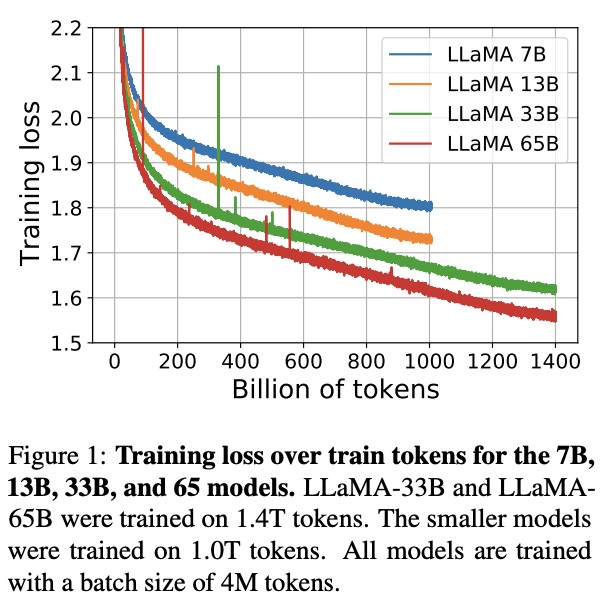

根据 Meta 官网介绍,LLaMA 包含 4 个基础模型,参数分别为 70 亿、130 亿、330 亿和 650 亿。其中,LLaMA 65B 和 LLaMA 33B 在 1.4 万亿个 tokens 上训练,而最小的模型 LLaMA 7B 也经过了 1 万亿个 tokens 的训练。

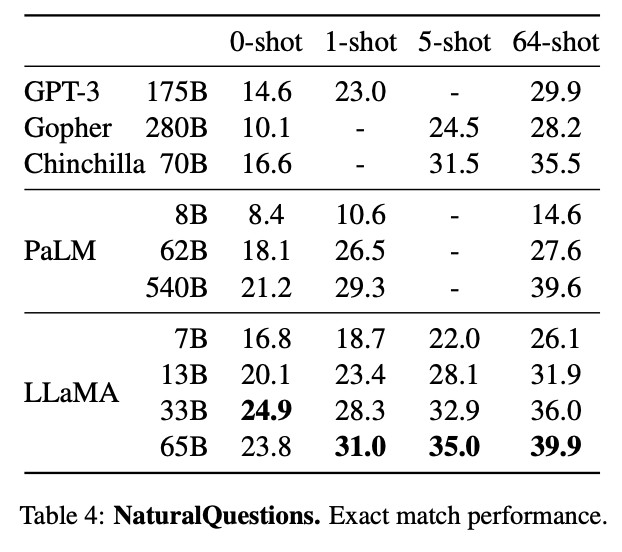

Meta 表示,在大多数基准测试中,参数小的多的 LLaMA-13B 的性能优于 GPT3.5 的前身 GPT3-175B,而 LLaMA-65B 更可与业内最佳的 Chinchilla-70B 和 PaLM-540B 竞争。值得一提的是,近期大火的 ChatGPT 便是由 GPT3.5 提供支持。

Meta 还提及,LLaMA-13B 对算力的要求 “低得多”,可以在单个数据中心级 GPU(Nvidia Tesla V100)上运行。

扎克伯格写道:

“Meta 致力于这种开放的研究模式,我们将向 AI 研究社区提供我们的新模型。”

值得一提的是,去年 5 月,Meta 也曾推出过大型语言模型 OPT-175B。该项目同样也是针对研究人员的,这构成了其聊天机器人 blenterbot 新迭代的基础。后来,该公司还推出了一款名为 “卡拉狄加”(Galactica) 的模型,但因经常分享偏见和不准确的信息而遭到下架。

据媒体报道,扎克伯格已将人工智能作为公司内部的首要任务,其本人也经常在财报电话会议和采访中谈论它对改进 Meta 产品的重要性。媒体分析称,虽然现在 LLaMA 没有在 Meta 产品中使用,但未来不排除使用的可能。