三個月誕生 79 個基礎大模型,中國到底需要什麼大模型?

大模型是不是豪華遊戲?大模型市場是否出現了泡沫?

去年年底 ChatGPT 發佈後,中國企業至少已經發布了 79 個基礎大模型。但其中絕大部分大模型都被外界認為技術上和 ChatGPT 存在差距。大模型商用箭在弦上,中國到底需要什麼大模型?

2022 年 12 月,微軟投資的 AI 創業公司 OpenAI 推出了對話式 AI ChatGPT。ChatGPT 本質是 OpenAI 自主研發的 GPT 語言大模型,該大模型包含近 1800 億個參數。今年 2 月英偉達 CEO 黃仁勳評價稱,“ChatGPT 讓 AI 迎來了 iPhone 時刻”。黃仁勳認為,大模型正在降低應用開發門檻,所有應用都值得用大模型重做一次。

這並不是黃仁勳的一家之言,所有人都看到了機會。

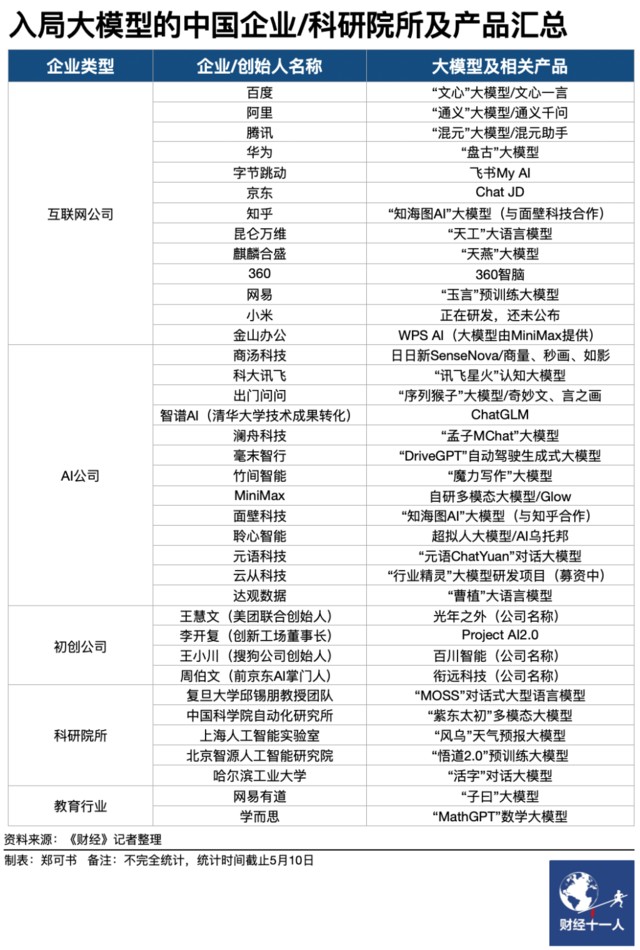

今年 3 月開始,中國企業也在競相發佈大模型產品。其中包括頭部企業,如百度的文心大模型、阿里的通義大模型、騰訊的行業大模型,還包括訊飛、商湯科技等行業企業以及一批創業公司。5 月科技部下屬的中國科學技術信息研究所發佈了《中國人工智能大模型地圖研究報告》。報告顯示,截至 5 月 28 日,國內 10 億級參數規模以上基礎大模型至少已發佈 79 個。

模型的參數量很重要。目前,百度、阿里等頭部公司公佈文心、通義參數量通常在 1000 億級別,如文心大模型參數量為 2600 億。其他企業或創業公司大模型參數量通常在 100 億、10 億級別。

雖然目前市場上發佈的 AI 模型都叫 “大模型”,但參數量被默認為是大模型、小模型的界定因素之一。百度集團副總裁侯震宇對《財經》記者表示,2022 年 10 億參數的模型,就叫大模型。但現在的大模型參數動輒上千億。因為千億參數以上才會出現 “智能湧現” 效應,才會形成泛化能力,才能在各個場景下具備通用能力。基於這種大模型精調出來的模型才具備更好的產業應用效果。

“智能湧現” 效應,指的是模型規模、算力水平超過某個參數閾值後,AI 效果將不再是隨機概率事件。在通用領域,參數量越大,智能通常湧現的可能性就越大,AI 準確率也會更高。在專用垂直領域,大參數模型裁剪優化後更容易獲得精確的效果。

雖然中國至少已經出現了 79 個大模型,但多位接受《財經》記者採訪的行業人士認為,大模型需要算力、算法、數據積累。由於高性能 GPU 芯片短缺,硬件採購成本、運營成本高昂,中國具備資金儲備、戰略意志和實際能力跑通大模型商業化的企業寥寥無幾。“百模大戰” 中,絕大部分產品和 ChatGPT 確實存在差距。

經歷喧囂後,大模型狂熱正在逐漸迴歸現實。國內外大模型市場正在出現更多理智思考——無法落地商用的 ChatGPT 只能是玩具,能成為企業應用的大模型才有產業價值。

蘋果、三星、摩根大通等企業因為安全考慮禁止員工使用 ChatGPT。另一方面,ChatGPT 用户增長、留存也已到瓶頸。網站分析工具 SimilarWeb 數據顯示,ChatGPT 在 1-5 月流量環比增速分別為 131.6%、62.5%、55.8%、12.6%、2.8%。6 月初,摩根士丹利調查顯示,只有 19% 的受訪者表示使用過 ChatGPT,只有 4% 的人表示依賴 ChatGPT。

侯震宇説,“今年 3 月,客户剛開始跟我們聊大模型需求時,都在發揮想象力,提的需求要多科幻有多科幻。但 4 月後,大模型的侷限性顯露,大家才慢慢看到了更多實際需求。” 主客觀因素影響下,全球基礎大模型均主要面向 To B 行業市場。

大模型在 To C 端商業化進程緩慢。目前面臨算力成本高昂,用户規模越大企業虧損越多等問題。也無法避免輸出錯誤 “噪音”,甚至還有信息泄密、政策監管等倫理挑戰。即使微軟,也只是在工具類產品(office 辦公套件、網頁瀏覽器、Photoshop 等修圖工具)中部署大模型。微軟向工具類企業賣服務,其本質仍是 To B 商業化。

大模型面向 To B 端企業客户落地才是務實做法。在行業市場,客户需求蓬勃且明確。在全球,零售、金融、製造、政府等領域都在靠大模型進行智能化升級。行業共識是,在大模型基礎上經過行業知識精調的模型,其特定工作表現,會優於未經優化的通用基礎大模型。

市場調研機構 IDC 在今年 5 月公佈的數據顯示,2022 年中國人工智能市場總規模為 122 億美元,其中硬件 81.3 億美元,軟件 26.9 億美元,服務 14.1 億美元。IDC 預測稱,2026 年中國人工智能市場規模將達到 269 億美元,其中硬件 148.5 億美元,軟件 76.9 億美元,服務 38.9 億美元。硬件、軟件、服務的年複合增長率分別為 15.1%、 32.0%、28.5%。

狂熱總要回歸現實。《財經》6 月與百度集團副總裁侯震宇、百度智能雲副總裁朱勇展開了一場主題名為 “中國到底需要什麼大模型” 的對話,侯震宇和朱勇深度參與了百度文心千帆大模型平台的打造和商用生態的塑造,在這場談話中,我們探討了三大問題:大模型是不是豪華遊戲?企業到底需要何種大模型?大模型市場是否出現了泡沫?

狂熱總要回歸現實。《財經》6 月與百度集團副總裁侯震宇、百度智能雲副總裁朱勇展開了一場主題名為 “中國到底需要什麼大模型” 的對話,侯震宇和朱勇深度參與了百度文心千帆大模型平台的打造和商用生態的塑造,在這場談話中,我們探討了三大問題:大模型是不是豪華遊戲?企業到底需要何種大模型?大模型市場是否出現了泡沫?

對話人簡介:

百度集團副總裁 侯震宇(負責百度智能雲事業羣組雲計算產研團隊和基礎技術工程團隊)

百度智能雲副總裁 朱勇(負責百度智能雲應用產品中心)

主持人:《財經》雜誌副主編 謝麗容

以下是對話實錄精華版:

大模型是不是豪華遊戲?

《財經》謝麗容:中國掀起了大模型創業潮,大模型的門檻很高,但從入局速度和規模看中國市場現狀似乎並非如此?

朱勇:大模型門檻是相對的,其中會有不同類型的玩家。第一類和百度一樣,從零開始做基礎大模型。這對算力、算法、數據、人才的要求都非常高。

以數據為例,基礎大模型需要海量數據訓練,其中包括互聯網數據、專業領域數據、新聞資訊數據,以及經過高質量的專業標註的數據。以算力為例,ChatGPT 這樣的千億級參數大模型,需要英偉達最高端的 A100/H100 GPU 連續訓練 100 天才能得到。算法、人才也是關鍵。工程師訓練手法不同,就像不同廚師基於同樣原材料做的菜口味都不一樣。這需要長期實踐經驗積累,所以門檻很高。

第二類是行業大模型,基於基礎大模型能力做一些微調、針對性定製。這比過去從零開始數據標註、算法精調的成本大大降低。第三類基於前兩類大模型開發應用,百度、其他企業甚至是一些開源平台都提供了開發工具,讓軟件開發門檻變得更低。

《財經》謝麗容:中國的大模型在全球市場究竟是什麼水平?

侯震宇:個人覺得中國的大模型在全球市場還是領先的。大模型研發和搜索引擎研發其實類似,都需要非常深的技術積累。從全球來看,擁有獨立研發搜索引擎技術的國家就那麼幾個。目前能完全獨立研發大模型技術的,可能也只有中美兩個國家。

《財經》謝麗容:大模型有沒有絕對的先進和落後?

侯震宇:大模型沒有絕對好、壞。儘管它在不同領域可能會有一定的差別,但就像選擇智能手機一樣。有人用蘋果,有人用安卓,最適合的才是好的。大模型剛推出時,經常會有人考它一些刁鑽的問題。但事實上,在真正嚴肅的企業級環境裏面,不太會有這樣的場景。企業需要針對業務場景選擇更適合自己的大模型。特別是中國企業,需要選擇中文理解力更好,適合中國企業特點的產品。

《財經》謝麗容:百度在大模型方向究投入了多少資源,多少人才?

侯震宇:AI 大模型是百度核心戰略,它需要持續全方位高強度投入。以算力為例,我們過去 GPU 數量的積累,是以萬為單位計量,這一筆巨大的投資。百度經過多年還開發出了一整套工具鏈,能夠更快更好地訓練模型。

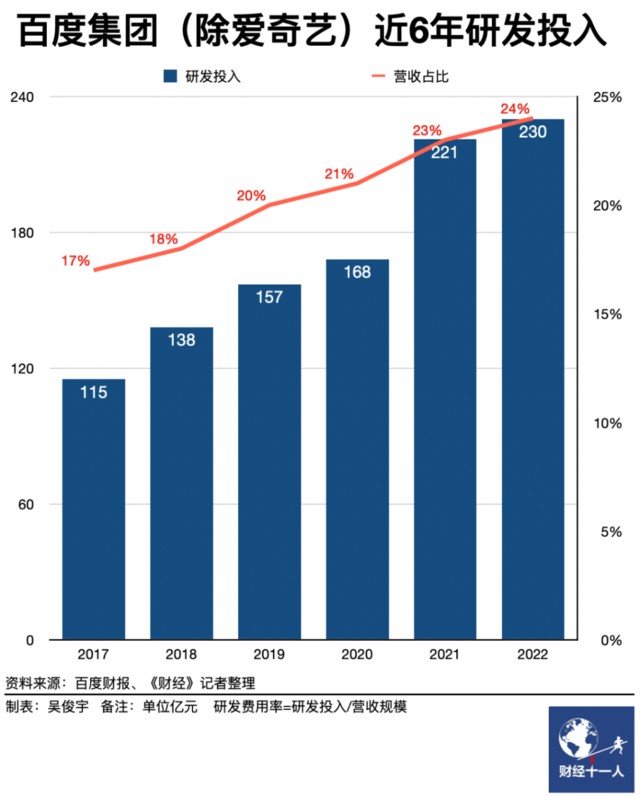

過去 10 年,百度在 AI 方向投入已超過 1000 億元。百度作為一家技術公司,每年研發投入的營收佔比都超過 20%。(備註:2019 年後,百度核心研發支出的營收佔比長期超過 20%。2022 年百度研發支出率為 24%,在中國科技企業中僅次於華為的 25%。百度核心指剔除愛奇藝後的百度自有業務)但大模型也不是投一筆錢、做一個模型那麼簡單,它需要有算力、有數據、有經驗豐富的 AI 工程師在好的研發平台上長期積累。

《財經》謝麗容:創業公司做基礎大模型,除了要有錢、要有卡、要有數據,還有哪些挑戰?

侯震宇:錢、卡、數據,本身就很有挑戰。創業公司做基礎大模型,除了起碼的算力,足夠多、質量好的數據,有經驗的 AI 研發人員,還需要能夠把模型、算力管理好的 AI 開發平台。目前大公司會把這些平台以雲的形式對外提供服務。比如,百度智能雲通過文心千帆大模型平台對外提供服務。但是從零開始訓練出基礎大模型門檻依然很高。因為大模型不是訓出來就行,還需要後續持續敏捷迭代,大公司相對會更成熟。

《財經》謝麗容:一些企業正在開始自建大模型。自建大模型是不是必須的選擇?2014 年公有云剛剛興起時,某些客户會擔心數據安全,它們使用大模型時,是否也會擔心這個問題?

侯震宇:每一家公司都一定要用大模型,但每一個企業是否都需要自己做一個大模型?我覺得不一定。自己從頭開始去做一個基礎大模型成本非常高。企業拿自己的數據在別人的基礎大模型做精調,一樣可以獲得非常好的效果。

朱勇:我覺得企業更多應該去想怎麼用上大模型,怎麼用好大模型。每個企業都可以擁有自己的大模型,但沒必要重新開始做。因為百度這樣的企業已經提供了很好的技術底座。可以依靠百度做一些定製化產品,這對客户來説是性價比更好的選擇。數據安全問題並不是大模型出現才帶來的新問題。如果類比雲計算的話,有公有云、私有云、託管等方式。在大模型商業模式上,我們已經充分考慮過相應的產品和解決方案。

《財經》謝麗容:智能手機、雲的普及都是因為價格足夠低。中國大模型什麼時候才能進入普遍應用階段?

侯震宇:大模型本身就帶來了大量成本節省。過去,企業研發 AI 應用時,需要根據應用場景做數據清洗、標註,對模型訓練、推理、優化。不管場景有多小,都得做全流程的工作,成本很高。但基於大模型,不需要過去那麼多數據、時間、資源、人力。我建議企業儘早關注、使用大模型技術,因為它本身就能大幅度降低 AI 應用門檻。

中國企業需要什麼大模型?

《財經》謝麗容:百度的文心大模型 3 月開始內測。內測中,企業是否可以清晰地提出自己的需求?他們的需求集中在哪些層面?

朱勇:距離 3 月份內測以來,我們已經陸續接到了超過 15 萬家客户的接入請求。同時也有幾百家合作伙伴跟我們在場景中進行研發測試。這覆蓋了互聯網、製造、金融等不同行業,裏面很多場景是高價值的。總結一下,比較高頻出現的場景有幾大類——知識管理、內容創作(包括營銷文案、媒體資訊)、智能客服、代碼生成和辦公提效。

《財經》謝麗容:數字化轉型市場長期存在一個問題,很多客户不知道自己想要什麼。在大模型領域,這個矛盾是不是也存在?

朱勇:不同行業、不同客户確實存在差別。大模型出來後,互聯網行業高度關注它的最新進展,他們的技術理解、產品認知都非常領先,因此我們能很快在一起進行研發測試,做出 Demo 和產品創新。

一些傳統產業的數字化基礎相對薄弱一些,所以百度會有大量工程師跟客户一起共創,將 AI 能力跟他們的行業痛點相結合,產生很多很新穎的產品理念。AI 技術跟行業相結合時,一方面要懂技術、懂 AI,另一方面要懂行業。所以我們跟客户、合作伙伴對接時,經常需要雙方在一起共創。

《財經》謝麗容:百度怎麼給不同行業、不同類型的客户提供大模型服務?從客户角度如何評估性價比?

朱勇:在價格層面,如果企業剛開始嘗試且對價格敏感,可以使用公有云服務,根據調用量,Pay-as-you-go (用多少花多少),不需要一次性基礎設施投入,這也是公有云的優勢。一些企業願意進行較大基礎設施投入,並建立自己智能化的應用,百度可以提供一整套 AI 模型和 AI 底座,企業可以基於 AI 模型和 AI 底座開發應用。

《財經》謝麗容:企業怎麼選擇適合自己的大模型?

侯震宇:第一,肯定是模型效果,這是選擇大模型的基礎。企業需要評估大模型在使用場景中能夠發揮的價值。第二,要關注迭代速度。既要看基礎大模型本身是否有生命力,也要看平台是否有完善的工具鏈,支持便捷的二次開發和模型再訓練,支撐大模型更好迭代。第三,大模型的實際落地成本和交付形態。企業可以根據需要選擇公有云、私有云的交付模式。

《財經》謝麗容:文心千帆被定位為一站式企業級大模型平台,怎麼去理解 “一站式”、“企業級”?

侯震宇:首先説 “一站式”, AI 是由數據驅動的技術。AI 從誕生之初就要做數據收集、清理、標註,再根據現有模型做訓練,訓練結束後要對精調數據、模型版本做管理,最後將其投放到業務中使用。這是一整套流程。百度提供了這些能力,而且很易用,客户在 AI 研發到應用的全生命週期中的需求都可以滿足。

再説 “企業級”,企業級應用不是個人應用,不是上傳照片那麼簡單。企業級應用會更精細、複雜,需要考慮規模化、擴展性、實施成本、穩定健壯等因素。

《財經》謝麗容:百度對外稱,文心千帆大模型平台有六大特點——易用、安全、全面、高效、開放、集成。易用為什麼要擺在第一個?是不是隻有好用的技術才會被普及?

侯震宇:易用非常重要。自然語言大模型可以給客户提供更易用的接口,方便大家和機器來做交互。“雲智一體,AI 普惠” 是百度智能雲的戰略,“AI 普惠” 也一直是我們的一個理想。AI 不能只是象牙塔裏高高在上的技術,必須要降低 AI 使用的門檻,其中包括數據使用門檻、資源使用門檻、以及人使用 AI 的門檻,所以易用非常關鍵。

《財經》謝麗容:過去三個月,公眾已經被很好地普及了人工智能大模型。對千行百業來説,大模型的商用時機是否已經到了?好的商用節奏應該是怎樣的?

朱勇:人工智能大模型對研發和應用範式的變革非常明確。越早擁抱大模型、理解大模型,越會讓它對業務產生作用。這不是 Yes or NO 的問題。談到節奏,不同企業擁抱大模型的方式不一樣。有的企業可以從單點應用嘗試開始,利用公有云調用服務,這樣可以更低成本地快速驗證做 Demo 開發。

另外一方面,無論是大小企業,都要培養 AI 原生思維。比如一些應用可以通過漸進式的方式進行改造升級。另一種做法叫重構,按照百度公司內部的説法,未來所有的產品都會基於大模型重新做一遍。

大模型市場出現泡沫了嗎?

《財經》謝麗容:在面向企業的 B 端市場真的需要那麼多大模型嗎?

侯震宇:我個人看法是,基礎大模型其實不需要那麼多。當然,這只是從終局往前看。但在任何一個行業發展早期,市場會變得繁榮且存在泡沫。從產業發展的角度來看,我們應該允許現在有一定的泡沫。我們也應該正視這一點。但我仍然相信,在大浪淘沙之後,最終提供基礎模型服務的,仍然是為數不多的幾個企業。

朱勇:基礎大模型方向,雖然現在有很多玩家,但是真正能夠保持快速迭代,不斷開發更全面、更完整工具鏈,不斷基於客户反饋來提升產品能力,這是一件挺難的事情。所以大模型雖然現在可能很熱,但這是長跑,最後會像今天的雲計算格局一樣,市場會逐漸收斂。

《財經》謝麗容:很多做服務器硬件的企業也要做行業大模型。百度曾經是他們的客户,現在變成互相競爭。我們應該怎樣和平共處?

侯震宇:我覺得不能直接説競爭,我們首先還是合作關係。雙方的確會有相近的服務,同時面對相近的行業,但我們和傳統硬件廠商更多還是互補關係。百度是一家互聯網基因的 AI 公司,積累了大量通用數據,有通用大模型,優勢在 AI、軟件、科技等領域。傳統硬件廠商積累了行業數據,在傳統政企行業等垂直領域打磨出了 Know-how。雙方在建大模型時的擅長點不一樣。百度和新華三等企業,既是服務器、交換機採買的合作伙伴,同時也會共建大模型。

《財經》謝麗容:百度平時會關注競爭對手的大模型在哪些方面的進展?

朱勇:第一,技術和整體效果。第二,配套工具。第三,商業模式。如果你再回到三四年前,人工智能市場還是比較遙遠,但今天深度學習的技術、產品商業化、投資、開源生態,都在加速發展。

《財經》謝麗容:未來幾年,大模型會是百度核心的重點方向嗎?為什麼?

侯震宇:大模型會是百度的核心重點方向。百度是一家 AI 公司,大模型是 AI 的重要發展方向。不管是在 To C 端,還是在 To B 端,它都將會給百度的產品、服務帶來巨大變化。對於百度來説,大模型讓人非常興奮,這既是機遇,也是挑戰。百度對大模型會持續投入,我相信大模型會讓雲計算加速進入 AI 時代,會重塑雲計算格局,MaaS(Model as a Service)的地位會變的越來越重要,也會加速實現百度智能雲提出的 “雲智一體” 戰略和 “AI 普惠” 理想。

《財經》謝麗容:2016 年開始的上一輪人工智能商業化出現了一些問題,AI 企業不得不做很多繁瑣細碎的定製化項目。大模型要如何規避上一輪人工智能商業化遇到的問題?

侯震宇:這一輪大模型產業落地,和十年前以深度學習為代表的 AI 產業落地是不一樣的。這是 AI 研發的新範式,和以前的投入不一樣。大模型出現之前,AI 最被詬病、落地最難的是,實際產業環境場景碎片化。比如閘機的人臉識別、支付的人臉識別都不一樣。因為光線、環境不一樣,需要面向不同應用,根據客户積累的數據從頭做訓練,再去拿到場景裏做適配。這種定製化交付非常煩瑣。

但在基礎大模型下,不需要太多精調數據,不需要訓練太多輪數,就可以獲得非常好的結果。基礎大模型解決眾多場景比以前容易很多。大模型的泛化能力比以前強很多。這和上一輪的 AI 落地不一樣。去年 10 億參數的模型,就叫大模型,但現在的模型參數動輒上千億。在千億參數以上,才會有智能湧現,才會有更強的泛化能力,才能在各個場景下具備通用能力。

《財經》謝麗容:當很多人都湧入到一個行業裏的時候,泡沫可能不可避免。大模型如果要良性發展,有哪些建議?

侯震宇:對大模型從業者的建議是,量力而行。不一定全部都由自己去做。而是考慮 AI 商業化落地,找到最適合自身能力的場景和鏈條。我們希望行業在早期快速發展時,允許有一定的泡沫。但政策對技術運用的監管、行業評價技術好壞的標準能達成共識。有標準可循,有規矩可依,這樣才能良性發展。

朱勇:還要轉變思維方式。大模型是分水嶺式的技術、顛覆式的技術。要保持開放心態、持續學習。

本文作者:吳俊宇,來源:財經十一人,原文標題:《三個月誕生 79 個基礎大模型,中國到底需要什麼大模型?》